Quem nunca apelou para o ChatGPT para perguntar se aquela dor de cabeça que não passa há dois dias é grave ou não, antes de procurar um médico? Esse tipo de consulta informal virou parte da rotina de muita gente, mesmo sabendo que uma IA não substitui um profissional de saúde.

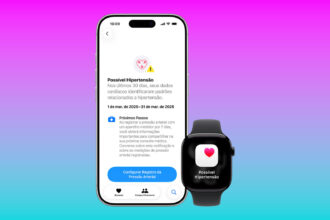

Agora, com o lançamento do ChatGPT Health, essa relação dá um passo além: o assistente passa a poder analisar dados reais de saúde do usuário, incluindo informações vindas do app Saúde. A promessa é tornar as respostas mais úteis e contextualizadas.

O desconforto, para muitos, é imediato. Até que ponto isso é prático, e quando começa a ficar invasivo?

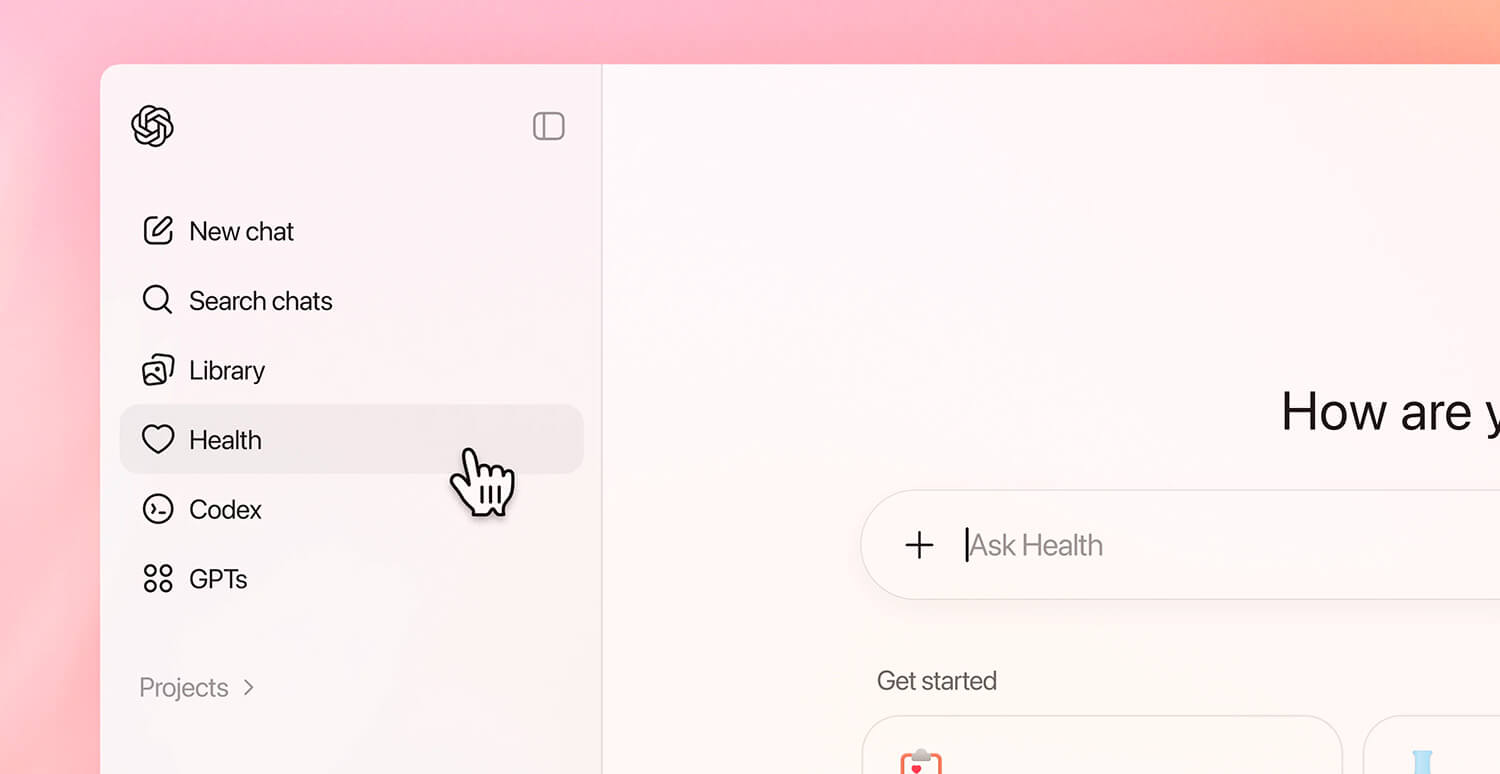

Novo ChatGPT Health

A ideia por trás do ChatGPT Health é simples de entender. Em vez de responder com base apenas em perguntas genéricas, o sistema pode considerar dados como sono, atividade física e outros registros que o próprio usuário já coleta no iPhone ou no Apple Watch.

Com isso, o ChatGPT consegue explicar padrões, ajudar a interpretar números e até auxiliar na preparação para uma consulta médica.

Não se trata de diagnóstico, segundo a OpenAI, mas de oferecer clareza onde antes havia apenas gráficos e estatísticas difíceis de interpretar.

Esse acesso, porém, não acontece automaticamente. O usuário precisa autorizar explicitamente a integração com o Apple Saúde, escolhendo exatamente quais dados deseja compartilhar.

É o mesmo modelo de permissões já usado por aplicativos de saúde no iOS. Nada é liberado sem consentimento, e o acesso pode ser revogado a qualquer momento.

Mas será que é seguro?

Do lado da OpenAI, a empresa afirma que criou um ambiente separado dentro do ChatGPT apenas para questões de saúde.

Os dados não se misturam com conversas comuns e não são usados para treinar modelos de inteligência artificial. Essa separação existe justamente porque informações de saúde exigem um nível de cuidado maior do que outros tipos de dado.

Na prática, a promessa é reduzir o risco de uso indevido ou exposição fora de contexto.

Mesmo assim, a desconfiança não é exagerada. Dados de saúde dizem muito sobre uma pessoa, seus hábitos e até suas fragilidades.

Ao permitir que um serviço externo processe esse tipo de informação, o usuário passa a depender não só da tecnologia atual, mas também das políticas futuras da empresa.

Regras podem mudar, leis variam entre países e nenhum sistema é imune a falhas. O receio não está necessariamente no que o ChatGPT faz hoje, mas no que pode vir a fazer amanhã.

E aí? Você confia?