A Apple quer mesmo mostrar que está trabalhando pesado em pesquisas de IA (Inteligência Artificial), que já é a grande promessa para a próxima WWDC em junho.

Nesta semana, a Apple revelou mais um projeto que promete elevar a interação humano-computador a um novo patamar.

Trata-se do Ferret LLM, um modelo de linguagem de última geração, cuja proposta é possibilitar que a Siri, assistente virtual da empresa, compreenda o layout dos aplicativos em uma tela de iPhone.

Este avanço poderia não apenas aumentar a capacidade da assistente digital da Apple, mas também transformar a maneira como interagimos com nossos dispositivos móveis.

E isso pode ser uma dica do que está vindo no próximo iOS 18.

Uma IA que lê a tela do celular

De acordo com um artigo recentemente publicado pela Cornell University, intitulado “Ferret-UI: Grounded Mobile UI Understanding with Multimodal LLMs“, o Ferret LLM é um modelo de linguagem multimodal (MLLM) inovador, desenvolvido para entender as interfaces de usuário (UI) de dispositivos móveis.

Este trabalho é fruto da colaboração entre pesquisadores da Cornell University e especialistas da Apple, unindo forças para superar os desafios atuais na compreensão de UI por parte das máquinas.

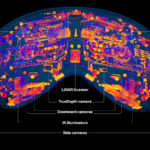

Historicamente, os modelos de linguagem têm encontrado dificuldades para interagir efetivamente com telas de interface de usuário, principalmente devido à orientação retrato dos dispositivos móveis, que compacta ícones e detalhes em um espaço reduzido.

O Ferret LLM aborda essa questão com um sistema de magnificação que permite escalar imagens para “qualquer resolução”, tornando ícones e texto mais legíveis.

Além disso, para processamento e treinamento, o Ferret divide a tela em duas seções menores, facilitando a identificação de elementos na tela.

Um dos aspectos mais fascinantes do Ferret LLM é sua capacidade de oferecer respostas contextuais.

Por exemplo, se um usuário perguntar como abrir o aplicativo Lembretes, o Ferret poderá orientar o usuário a tocar no botão “Abrir” na tela.

Isso não só demonstra a habilidade do modelo em entender consultas do usuário, mas também sua capacidade de interagir com elementos gráficos dentro de um aplicativo.

Além de melhorar a funcionalidade de assistentes virtuais como a Siri, o Ferret LLM tem o potencial de beneficiar significativamente pessoas com deficiência visual, oferecendo-lhes uma maneira mais intuitiva de entender e interagir com o conteúdo da tela.

Ao descrever detalhadamente o que está sendo exibido e, potencialmente, realizar ações em nome do usuário, o Ferret LLM pode revolucionar a acessibilidade em dispositivos móveis.

Embora ainda não esteja claro se e quando o Ferret LLM será integrado a sistemas como a Siri, a perspectiva de um controle avançado sobre dispositivos como o iPhone é empolgante.

A capacidade de executar ações em aplicativos, selecionando elementos gráficos de forma autônoma, poderia simplificar enormemente nossa interação diária com a tecnologia.

À medida que nos aproximamos da WWDC 2024, a expectativa é que mais novidades sobre este e outros projetos de IA da Apple sejam reveladas, pois a empresa precisa mostrar a seus acionistas de que está empenhada nisso.

E as expectativas para o iOS 18 só aumentam…