Apple anuncia novo método para treinamento de Modelos de Linguagem com integração de texto e imagem

Com a explosão da inteligência artificial e a impressão de que a Apple ficou para trás neste campo, a empresa de Tim Cook está se esforçando para mostrar que está trabalhando pesado nisso nos últimos meses.

Alguns pesquisadores da Apple alcançaram um marco importante no campo da inteligência artificial com o desenvolvimento de um novo método para treinar grandes modelos de linguagem (LLMs) que integra de maneira fluida informações textuais e visuais.

Detalhado esta semana no artigo de pesquisa intitulado “MM1: Métodos, Análise & Insights do Pré-treinamento de LLM Multimodal“, este avanço promete revolucionar a maneira como as máquinas compreendem e interagem com o mundo ao redor.

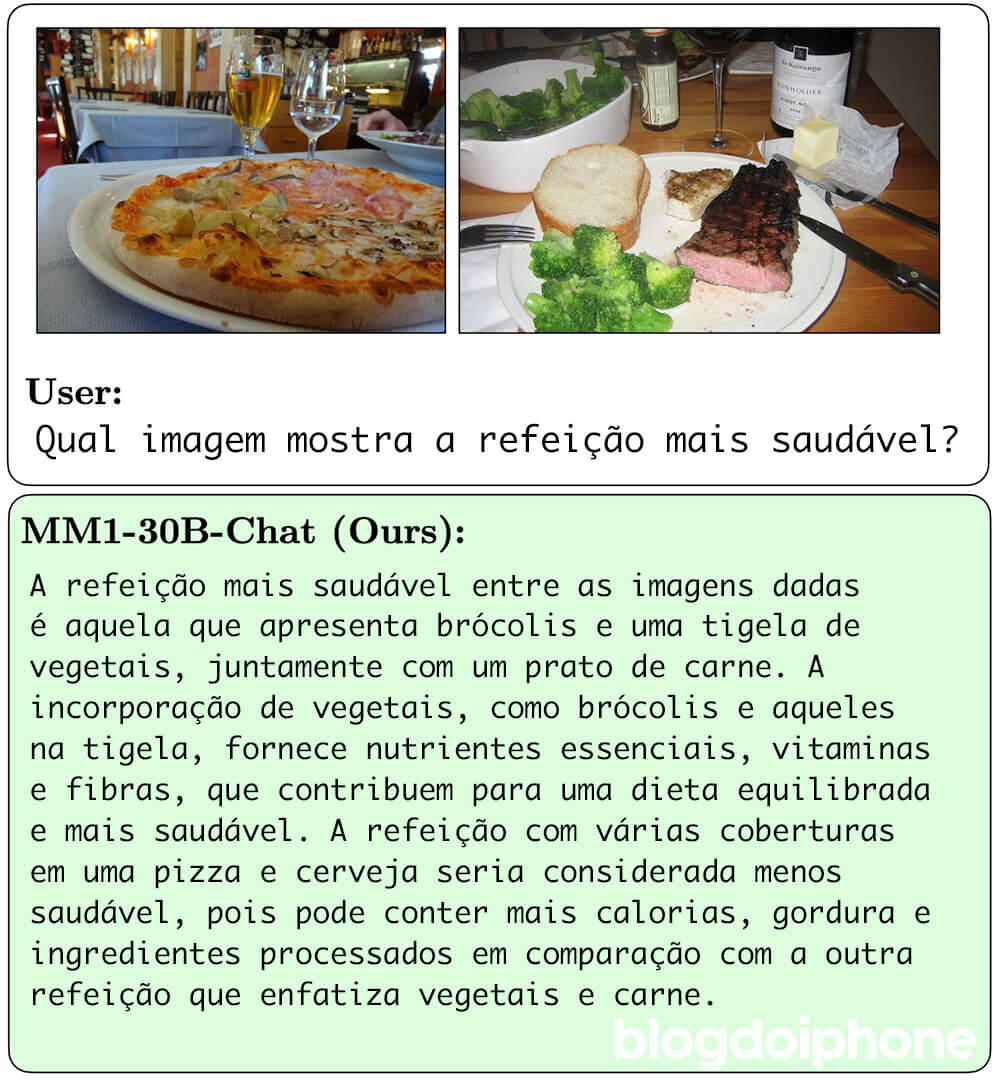

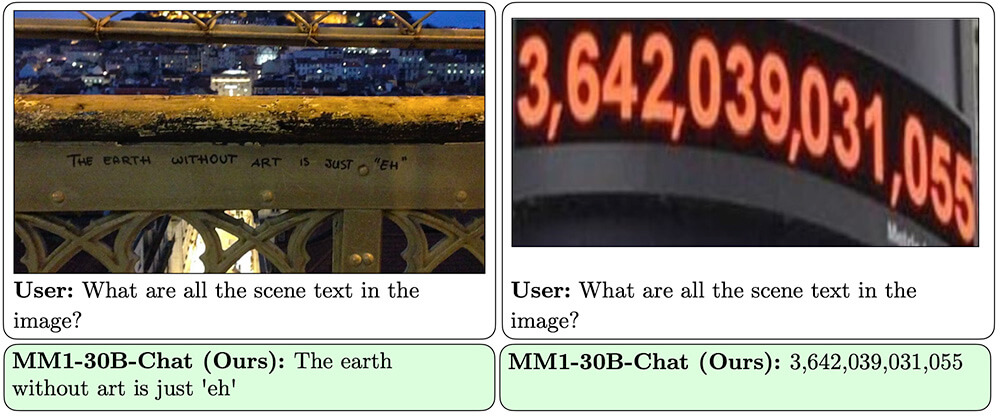

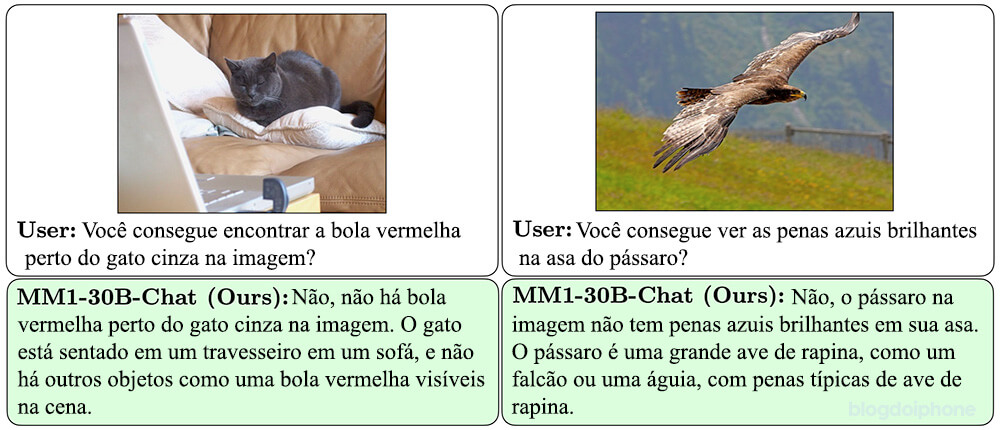

O modelo MM1, fruto desta pesquisa, destaca-se por sua habilidade em realizar tarefas complexas como a legendagem de imagens, a resposta a perguntas visuais e a inferência de linguagem natural com alta precisão.

Para alcançar esse feito, o método emprega uma abordagem multimodal, utilizando um conjunto de dados diversificado que inclui pares de imagem e legenda, documentos que intercalam texto e imagem, além de dados exclusivamente textuais.

A máquina interpretando o contexto

Uma das principais funcionalidades apresentadas pelo MM1 é sua capacidade de compreender e gerar linguagem a partir de uma combinação de dicas visuais e linguísticas.

Isso é particularmente valioso para tarefas que exigem uma compreensão detalhada do contexto, como a interpretação de imagens complexas ou o fornecimento de respostas a perguntas que envolvem elementos visuais.

Além disso, o modelo demonstrou habilidades excepcionais de aprendizado em contexto, especialmente na sua configuração de 30 bilhões de parâmetros.

Essa versão do MM1 mostrou ser capaz de realizar raciocínios complexos de múltiplos passos sobre várias imagens, utilizando a técnica de “encadeamento de pensamento” com poucos exemplos.

Tal habilidade sublinha o potencial do modelo para resolver problemas complexos e abertos com base em um número mínimo de exemplos, estabelecendo um novo padrão para a capacidade de raciocínio e resolução de problemas de IA.

Este desenvolvimento é parte dos esforços da Apple para avançar suas capacidades em inteligência artificial, em um momento em que a competição no setor tecnológico está cada vez mais acirrada.

Relatos recentes sugerem que a empresa está em negociações com o Google para licenciar modelos generativos de linguagem, como o Gemini, para incorporar em novas funcionalidades previstas para o iPhone no lançamento do iOS 18.

O que é LLM?

LLM, ou Large Language Models (Modelos de Linguagem de Grande Escala), são sistemas de inteligência artificial projetados para entender, gerar e interagir com texto humano de maneira coerente e contextual.

Eles são treinados em vastos conjuntos de dados de texto para aprender padrões de linguagem, gramática, conhecimento do mundo e vários outros aspectos da comunicação humana.

Essa capacidade de processar e gerar linguagem os torna úteis em uma variedade de aplicações, incluindo tradução automática, geração de texto, resumo de texto, compreensão de perguntas e respostas, e muito mais.

Modelos como o GPT (Generative Pre-trained Transformer) da OpenAI são exemplos de LLMs que demonstraram capacidades avançadas em muitas tarefas de processamento de linguagem natural.

A Apple conseguirá nos surpreender?

A fabricante do iPhone tem dinheiro e aparentemente muita disposição para correr atrás do tempo perdido e apresentar ao mundo inovações nesta área.

Pelo menos é o que tanto os acionistas quanto os usuários esperam da empresa que sempre ditou o rumo da inovação tecnológica. E sabe-se lá o que a Apple aprendeu enquanto tentava desenvolver seu próprio carro autônomo…

➽ Apple teria investido mais de 10 bilhões de dólares no seu projeto de carro, segundo o New York Times